Olá, pessoal, bem-vindos ao boletim informativo regular de IA do TechCrunch. Se você quiser isso em sua caixa de entrada todas as quartas-feiras, inscreva-se aqui.

Esta semana, na IA, os dados sintéticos ganharam destaque.

A OpenAI apresentou na última quinta-feira o Canvas, uma nova maneira de interagir com Bate-papoGPTsua plataforma de chatbot com tecnologia de IA. Tela abre uma janela com um espaço de trabalho para escrever e codificar projetos. Os usuários podem gerar texto ou código no Canvas e, se necessário, destacar seções para editar usando ChatGPT.

Da perspectiva do usuário, o Canvas é uma grande melhoria na qualidade de vida. Mas o que é maioria interessante sobre o recurso, para nós, é o modelo ajustado que o alimenta. OpenAI diz que adaptou seu GPT-4o modelo usando dados sintéticos para “permitir novas interações do usuário” no Canvas.

“Usamos novas técnicas de geração de dados sintéticos, como destilar resultados de OpenAI’s o1-visualizaçãopara ajustar o GPT-4o para abrir a tela, fazer edições direcionadas e deixar comentários de alta qualidade inline”, escreveu o chefe de produto do ChatGPT, Nick Turley, em um postar no X. “Essa abordagem nos permitiu melhorar rapidamente o modelo e permitir novas interações do usuário, tudo sem depender de dados gerados por humanos.”

A OpenAI não é a única grande empresa de tecnologia que depende cada vez mais de dados sintéticos para treinar seus modelos.

Em desenvolvimento Gerador de filmesum conjunto de ferramentas alimentadas por IA para criar e editar videoclipes, o Meta dependia parcialmente de legendas sintéticas geradas por uma ramificação de seu Lhama 3 modelos. A empresa recrutou uma equipe de anotadores humanos para corrigir erros e adicionar mais detalhes a essas legendas, mas a maior parte do trabalho de base foi amplamente automatizado.

O CEO da OpenAI, Sam Altman, argumentou que a IA irá algum dia produzir dados sintéticos bons o suficiente para se treinar de forma eficaz. Isso seria vantajoso para empresas como a OpenAI, que gasta uma fortuna em anotadores humanos e licenças de dados.

A Meta ajustou os próprios modelos do Llama 3 usando dados sintéticos. E diz-se que a OpenAI está fornecendo dados de treinamento sintéticos da o1 para seu modelo de próxima geração, de codinome Orion.

Mas adotar uma abordagem que prioriza os dados sintéticos traz riscos. Como um pesquisador recentemente me apontou, os modelos usados para gerar dados sintéticos inevitavelmente alucinam (ou seja, inventam coisas) e contêm preconceitos e limitações. Essas falhas se manifestam nos dados gerados pelos modelos.

O uso seguro de dados sintéticos, portanto, requer curadoria e filtragem completas – como é a prática padrão com dados gerados por humanos. Não fazer isso poderia levar ao colapso do modeloonde um modelo se torna menos “criativo” — e mais tendencioso — nos seus resultados, comprometendo eventualmente seriamente a sua funcionalidade.

Esta não é uma tarefa fácil em escala. Mas com os dados de treinamento do mundo real se tornando mais caro (para não mencionar o desafio de obter), os fornecedores de IA podem ver os dados sintéticos como o único caminho viável a seguir. Esperemos que eles tenham cautela ao adotá-lo.

Notícias

Anúncios em visões gerais de IA: o Google diz que em breve começará a exibir anúncios em Visão geral de IAos resumos gerados por IA que fornece para determinadas consultas da Pesquisa Google.

Google Lens, agora com vídeo: Lens, o aplicativo de pesquisa visual do Google, foi atualizado com a capacidade de responder perguntas quase em tempo real sobre o que está ao seu redor. Você pode capturar um vídeo via Lens e fazer perguntas sobre objetos de interesse no vídeo. (Anúncios provavelmente virão para isso também.)

De Sora a DeepMind: Tim Brooks, um dos líderes do gerador de vídeo da OpenAI, Sorapartiu para o rival Google DeepMind. Brooks anunciou em um post no X que trabalhará em tecnologias de geração de vídeo e “simuladores mundiais”.

Fluxando: Black Forest Labs, a startup apoiada por Andreessen Horowitz por trás do componente de geração de imagens de xAI’s Grok assistente, lançou uma API em beta — e lançou um novo modelo.

Não tão transparente: O projeto de lei AB-2013 recentemente aprovado na Califórnia exige que as empresas que desenvolvem sistemas generativos de IA publiquem um resumo de alto nível dos dados que usaram para treinar seus sistemas. Até agora, poucas empresas estão dispostas a dizer se irão cumprir. A lei lhes dá até janeiro de 2026.

Artigo de pesquisa da semana

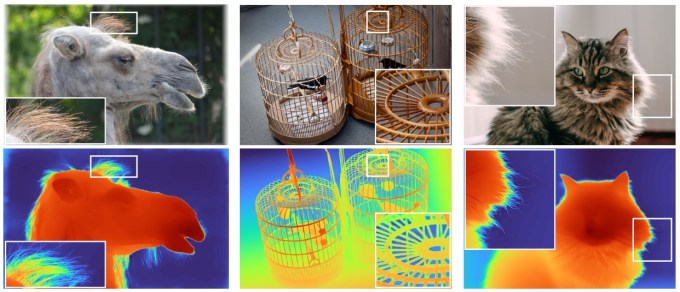

Os pesquisadores da Apple têm trabalhado arduamente em fotografia computacional há anos, e um aspecto importante desse processo é o mapeamento de profundidade. Originalmente, isso era feito com estereoscopia ou um sensor de profundidade dedicado, como uma unidade lidar, mas eles tendem a ser caros, complexos e ocupam um espaço interno valioso. Fazer isso estritamente por software é preferível de várias maneiras. É disso que trata este artigo, Depth Pro.

UMleksei Bochkovskii et al. compartilhar um método para estimativa de profundidade monocular de disparo zero com alto detalhe, o que significa que ele usa uma única câmera, não precisa ser treinado em coisas específicas (como funciona em um camelo, apesar de nunca ter visto um) e captura até mesmo aspectos difíceis, como tufos de cabelo . É quase certo que esteja em uso em iPhones no momento (embora provavelmente seja uma versão aprimorada e personalizada), mas você pode tentar se quiser fazer sua própria estimativa de profundidade usando o código nesta página do GitHub.

Modelo da semana

O Google lançou um novo modelo em sua família Gemini, Gemini 1.5 Flash-8B, que afirma estar entre os de melhor desempenho.

Uma versão “destilada” de Gêmeos 1.5 Flashque já foi otimizado para velocidade e eficiência, o Gemini 1.5 Flash-8B custa 50% menos para usar, tem latência mais baixa e vem com limites de taxa 2x mais altos em Estúdio de IAo ambiente de desenvolvedor focado em IA do Google.

“O Flash-8B quase corresponde ao desempenho do modelo Flash 1.5 lançado em maio em muitos benchmarks”, escreve o Google em um postagem no blog. “Nossos modelos [continue] ser informado pelo feedback do desenvolvedor e por nossos próprios testes sobre o que é possível.”

Gemini 1.5 Flash-8B é adequado para bate-papo, transcrição e tradução, diz o Google, ou qualquer outra tarefa que seja “simples” e de “alto volume”. Além do AI Studio, o modelo também está disponível gratuitamente por meio da API Gemini do Google, com taxa limitada a 4.000 solicitações por minuto.

Sacola

Falando em IA barata, a Anthropic lançou um novo recurso, Message Batches API, que permite aos desenvolvedores processar grandes quantidades de consultas de modelos de IA de forma assíncrona por menos dinheiro.

Semelhante às solicitações em lote do Google para a API Gemini, os desenvolvedores que usam a API Message Batches da Anthropic podem enviar lotes de até um determinado tamanho – 10.000 consultas – por lote. Cada lote é processado em um período de 24 horas e custa 50% menos que as chamadas de API padrão.

A Anthropic afirma que a API Message Batches é ideal para tarefas de “grande escala”, como análise de conjuntos de dados, classificação de grandes conjuntos de dados e avaliações de modelos. “Por exemplo”, escreve a empresa em um publicar“analisar repositórios inteiros de documentos corporativos — que podem envolver milhões de arquivos — torna-se mais viável economicamente ao aproveitar [this] desconto em lote.”

A API Message Batches está disponível em versão beta pública com suporte para Anthropic’s Soneto de Cláudio 3.5, Cláudio 3 Opuse Claude 3 Haiku modelos.