É possível que uma IA seja treinada apenas com dados gerados por outra IA? Pode parecer uma ideia estúpida. Mas já existe há algum tempo – e à medida que é cada vez mais difícil obter dados novos e reais, tem vindo a ganhar força.

A Anthropic usou alguns dados sintéticos para treinar um de seus principais modelos, Soneto de Cláudio 3.5. Meta ajustou seu Lhama 3.1 modelos usando dados gerados por IA. E diz-se que a OpenAI está obtendo dados de treinamento sintéticos de o1seu modelo de “raciocínio”, para o próximo Órion.

Mas por que a IA precisa de dados em primeiro lugar – e o que tipo de dados ele precisa? E esses dados podem realmente ser substituído por dados sintéticos?

A importância das anotações

Os sistemas de IA são máquinas estatísticas. Treinados em vários exemplos, eles aprendem os padrões desses exemplos para fazer previsões, como “para quem” em um e-mail normalmente precede “pode interessar”.

As anotações, geralmente textos que rotulam o significado ou partes dos dados que esses sistemas ingerem, são uma peça-chave nesses exemplos. Eles servem como guias, “ensinando” um modelo para distinguir entre coisas, lugares e ideias.

Considere um modelo de classificação de fotos que mostra muitas fotos de cozinhas rotuladas com a palavra “cozinha”. À medida que treina, o modelo começará a fazer associações entre “cozinha” e geral características das cozinhas (por exemplo, que contenham frigoríficos e bancadas). Após o treinamento, diante de uma foto de uma cozinha que não constava nos exemplos iniciais, o modelo deverá ser capaz de identificá-la como tal. (É claro que se as imagens das cozinhas fossem rotuladas como “vacas”, isso as identificaria como vacas, o que enfatiza a importância de uma boa anotação.)

O apetite pela IA e a necessidade de fornecer dados rotulados para o seu desenvolvimento aumentaram o mercado de serviços de anotação. Dimensão Pesquisa de Mercado estimativas que vale hoje 838,2 milhões de dólares – e que valerá 10,34 mil milhões de dólares nos próximos dez anos. Embora não existam estimativas precisas de quantas pessoas se envolvem no trabalho de rotulagem, um estudo de 2022 papel fixa o número na casa dos “milhões”.

Grandes e pequenas empresas dependem de trabalhadores contratados por empresas de anotação de dados para criar rótulos para conjuntos de treinamento em IA. Alguns destes empregos pagam razoavelmente bem, especialmente se a rotulagem exigir conhecimentos especializados (por exemplo, conhecimentos de matemática). Outros podem ser exaustivos. Anotadores em países em desenvolvimento recebem em média apenas alguns dólares por hora sem quaisquer benefícios ou garantias de shows futuros.

Um poço de dados de secagem

Portanto, há razões humanísticas para procurar alternativas aos rótulos gerados pelo homem. Mas também existem alguns práticos.

Os humanos só conseguem rotular até certo ponto. Os anotadores também têm preconceitos que podem se manifestar em suas anotações e, posteriormente, em quaisquer modelos treinados nelas. Os anotadores fazem errosou obter tropeçou através das instruções de rotulagem. E pagar humanos para fazerem coisas é caro.

Dados em geral é caro, aliás. A Shutterstock está cobrando dos fornecedores de IA dezenas de milhões de dólares para acessar seus arquivosenquanto Reddit tem ganhou centenas de milhões com o licenciamento de dados para Google, OpenAI e outros.

Por último, os dados também estão se tornando mais difíceis de adquirir.

A maioria dos modelos é treinada em coleções massivas de dados públicos – dados que os proprietários estão cada vez mais optando por bloquear, por medo de que seus dados sejam plagiadoou que não receberão crédito ou atribuição por isso. Mais de 35% dos 1.000 principais sites do mundo agora bloqueie o web scraper da OpenAI. E cerca de 25% dos dados provenientes de fontes de “alta qualidade” foram restringidos dos principais conjuntos de dados usados para treinar modelos, um estudo recente estudar encontrado.

Caso a tendência atual de bloqueio de acesso continue, o grupo de pesquisa Epoch AI projetos que os desenvolvedores ficarão sem dados para treinar modelos generativos de IA entre 2026 e 2032. Isso, combinado com o medo de ações judiciais de direitos autorais e material questionável abrindo caminho para conjuntos de dados abertos, forçou um ajuste de contas para os fornecedores de IA.

Alternativas sintéticas

À primeira vista, os dados sintéticos parecem ser a solução para todos estes problemas. Precisa de anotações? Gere-os. Mais dados de exemplo? Sem problemas. O céu é o limite.

E até certo ponto, isso é verdade.

“Se ‘os dados são o novo petróleo’, os dados sintéticos se apresentam como biocombustível, criáveis sem as externalidades negativas da coisa real”, disse Os Keyes, candidato a doutorado na Universidade de Washington que estuda o impacto ético das tecnologias emergentes, ao TechCrunch . “Você pode pegar um pequeno conjunto inicial de dados e simular e extrapolar novas entradas a partir dele.”

A indústria de IA pegou o conceito e o seguiu.

Este mês, a Writer, uma empresa de IA generativa com foco empresarial, lançou um modelo, Palmyra X 004, treinado quase inteiramente em dados sintéticos. Seu desenvolvimento custou apenas US $ 700.000, afirma o escritor – comparado com estimativas de US$ 4,6 milhões para um modelo OpenAI de tamanho comparável.

da Microsoft Fi modelos abertos foram treinados usando dados sintéticos, em parte. O mesmo aconteceu com o Google Gema modelos. Nvidia este verão revelou uma família de modelos projetada para gerar dados de treinamento sintéticos, e a startup de IA Hugging Face lançou recentemente o que afirma ser o maior conjunto de dados de treinamento de IA de texto sintético.

A geração de dados sintéticos tornou-se um negócio por si só – um negócio que poderia ser valor US$ 2,34 bilhões até 2030. Gartner prevê que 60% dos dados utilizados para projetos de IA e análise este ano serão gerados sinteticamente.

Luca Soldaini, pesquisador sênior do Allen Institute for AI, observou que técnicas de dados sintéticos podem ser usadas para gerar dados de treinamento em um formato que não é facilmente obtido por meio de scraping (ou mesmo de licenciamento de conteúdo). Por exemplo, no treinamento do seu gerador de vídeo Gerador de filmesMeta usou o Llama 3 para criar legendas para filmagens nos dados de treinamento, que os humanos refinaram para adicionar mais detalhes, como descrições da iluminação.

Na mesma linha, a OpenAI diz que ajustou GPT-4o usando dados sintéticos para construir o tipo de bloco de desenho Tela recurso para ChatGPT. E a Amazon tem disse que gera dados sintéticos para complementar os dados do mundo real que usa para treinar modelos de reconhecimento de fala para Alexa.

“Modelos de dados sintéticos podem ser usados para expandir rapidamente a intuição humana sobre quais dados são necessários para atingir um comportamento de modelo específico”, disse Soldaini.

Riscos sintéticos

Contudo, os dados sintéticos não são uma panacéia. Ela sofre do mesmo problema de “entra lixo, sai lixo” que toda IA. Modelos criar dados sintéticos, e se os dados utilizados para treinar estes modelos tiverem preconceitos e limitações, os seus resultados serão igualmente contaminados. Por exemplo, grupos mal representados nos dados de base o serão nos dados sintéticos.

“O problema é que você não pode fazer muito”, disse Keyes. “Digamos que você tenha apenas 30 negros em um conjunto de dados. Extrapolar pode ajudar, mas se essas 30 pessoas forem todas de classe média, ou todas de pele clara, é assim que todos os dados “representativos” serão.”

Até este ponto, um 2023 estudar por pesquisadores da Rice University e de Stanford descobriram que a dependência excessiva de dados sintéticos durante o treinamento pode criar modelos cuja “qualidade ou diversidade diminui progressivamente”. O viés de amostragem – má representação do mundo real – faz com que a diversidade de um modelo piore após algumas gerações de treinamento, de acordo com os pesquisadores (embora eles também tenham descoberto que misturar alguns dados do mundo real ajuda a mitigar isso).

Keyes vê riscos adicionais em modelos complexos, como o o1 da OpenAI, que ele acredita que poderiam produzir resultados mais difíceis de detectar alucinações em seus dados sintéticos. Estes, por sua vez, poderiam reduzir a precisão dos modelos treinados nos dados – especialmente se as fontes das alucinações não forem fáceis de identificar.

“Modelos complexos alucinam; os dados produzidos por modelos complexos contêm alucinações”, acrescentou Keyes. “E com um modelo como o1, os próprios desenvolvedores não podem necessariamente explicar por que os artefatos aparecem.”

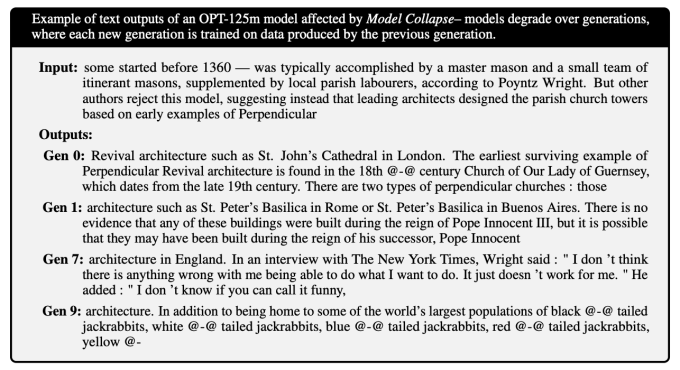

A combinação de alucinações pode levar a modelos que vomitam coisas sem sentido. UM estudar publicado na revista Nature revela como modelos, treinados em dados cheios de erros, geram ainda mais dados cheios de erros e como esse ciclo de feedback degrada futuras gerações de modelos. Os modelos perdem a compreensão do conhecimento mais esotérico ao longo das gerações, descobriram os investigadores – tornando-se mais genéricos e muitas vezes produzindo respostas irrelevantes para as perguntas que lhes são feitas.

Um acompanhamento estudar mostra que outros tipos de modelos, como geradores de imagens, não estão imunes a esse tipo de colapso:

Soldaini concorda que não se deve confiar em dados sintéticos “brutos”, pelo menos se o objetivo for evitar o treinamento de chatbots esquecidos e geradores de imagens homogêneos. Usá-lo “com segurança”, diz ele, requer revisão, curadoria e filtragem completas e, de preferência, combiná-los com dados novos e reais – assim como você faria com qualquer outro conjunto de dados.

Não fazer isso poderia eventualmente levar ao colapso do modeloonde um modelo se torna menos “criativo” — e mais tendencioso — nos seus resultados, comprometendo eventualmente seriamente a sua funcionalidade. Embora este processo possa ser identificado e detido antes de se tornar grave, é um risco.

“Os pesquisadores precisam examinar os dados gerados, repetir o processo de geração e identificar salvaguardas para remover pontos de dados de baixa qualidade”, disse Soldaini. “Os pipelines de dados sintéticos não são uma máquina de autoaperfeiçoamento; seus resultados devem ser cuidadosamente inspecionados e melhorados antes de serem usados para treinamento.”

O CEO da OpenAI, Sam Altman, argumentou certa vez que a IA algum dia produzir dados sintéticos bons o suficiente para treinar-se com eficácia. Mas – supondo que isso seja viável – a tecnologia ainda não existe. Nenhum grande laboratório de IA lançou um modelo treinado apenas em dados sintéticos.

Pelo menos no futuro próximo, parece que precisaremos de humanos informados em algum lugar para garantir que o treinamento de um modelo não dê errado.