- Microsoft revela hardware Maia 200 AI

- Maia 200 supostamente oferece mais desempenho e eficiência do que os rivais AWS e GCP

- A Microsoft o usará para ajudar a melhorar o Copilot internamente, mas também estará disponível para os clientes

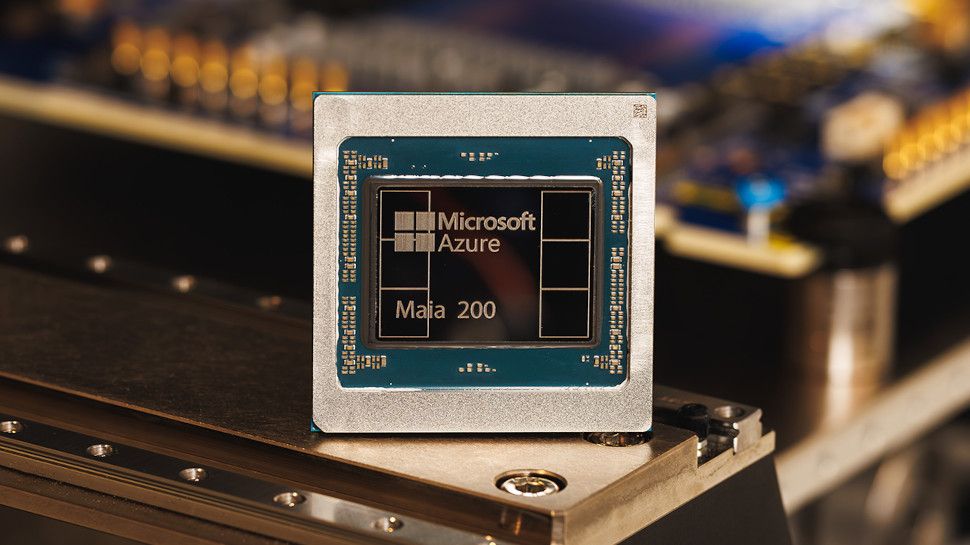

Microsoft revelou o Maia 200, seu “próximo grande marco” no suporte à próxima geração de IA e tecnologia de inferência.

O novo hardware da empresa, sucessor do Maia 100irá “mudar drasticamente a economia da IA em grande escala”, oferecendo uma atualização significativa em termos de desempenho e eficiência para reivindicar uma posição no mercado.

O lançamento também buscará promover o Microsoft Azure como um ótimo lugar para executar modelos de IA de forma mais rápida e eficiente, à medida que busca enfrentar seus grandes rivais Amazônia Serviços Web e Google Nuvem.

Microsoft Maia 200

A Microsoft diz que o Maia 200 contém mais de 100 bilhões de transistores construídos no processo TSMC 3nm com núcleos tensores FP8/FP4 nativos, um sistema de memória redesenhado com 216 GB HBM3e a 7 TB/s e 272 MB de SRAM no chip.

Tudo isso contribui para a capacidade de fornecer mais de 10 PFLOPS com precisão de 4 bits (FP4) e cerca de 5 PFLOPS de desempenho de 8 bits (FP8) – com facilidade suficiente para executar até mesmo os maiores modelos de IA atuais e com espaço para crescer à medida que a tecnologia evolui.

A Microsoft afirma que o Maia 200 oferece 3x o desempenho do FP4 do hardware Amazon Trainium de terceira geração e o desempenho do FP8 acima do TPU de sétima geração do Google, tornando-o o sistema de inferência mais eficiente da empresa até agora.

E graças ao seu design otimizado, que vê o subsistema de memória centrado em tipos de dados de precisão estreita, um mecanismo DMA especializado, SRAM on-die e uma estrutura NoC especializada para movimentação de dados de alta largura de banda, o Maia 200 é capaz de manter mais pesos e dados locais de um modelo, o que significa que menos dispositivos são necessários para executar um modelo.

A Microsoft já está usando o novo hardware para potencializar suas cargas de trabalho de IA no Microsoft Foundry e no Microsoft 365 Copilot, com maior disponibilidade para os clientes em breve.

A empresa também está lançando o Maia 200 em sua região de datacenter Central dos EUA agora, com novas implantações chegando em sua região de datacenter US West 3, perto de Phoenix, Arizona, em breve, e regiões adicionais definidas a seguir.

Para aqueles que desejam dar uma olhada antecipada, a Microsoft está convidando acadêmicos, desenvolvedores, laboratórios de IA de ponta e contribuidores de projetos de modelo de código aberto para se inscreverem agora para uma prévia do novo kit de desenvolvimento de software (SDK) Maia 200.

Siga o TechRadar no Google Notícias e adicione-nos como fonte preferencial para receber notícias, análises e opiniões de especialistas em seus feeds. Certifique-se de clicar no botão Seguir!

E é claro que você também pode Siga o TechRadar no TikTok para notícias, análises, unboxings em formato de vídeo e receba atualizações regulares nossas em WhatsApp também.