Olá pessoal, bem-vindos ao boletim informativo inaugural de IA do TechCrunch. É realmente uma emoção digitar essas palavras – esta está sendo preparada há muito tempo e estamos entusiasmados em finalmente compartilhá-la com você.

Com o lançamento do boletim informativo de IA do TC, estamos descontinuando This Week in AI, a coluna semirregular anteriormente conhecida como Perceptron. Mas você encontrará todas as análises que trouxemos para This Week in AI e maisincluindo destaque para novos modelos de IA notáveis, bem aqui.

Esta semana, na IA, os problemas estão surgindo – novamente – para a OpenAI.

Um grupo de ex-funcionários da OpenAI falou com Kevin Roose, do The New York Times, sobre o que eles consideram falhas de segurança flagrantes dentro da organização. Eles – como outros que deixaram a OpenAI nos últimos meses – afirmam que a empresa não está fazendo o suficiente para evitar que seus sistemas de IA se tornem potencialmente perigosos e acusam a OpenAI de empregar táticas duras para tentar impedir que os trabalhadores soem o alarme.

O grupo publicou uma carta aberta na terça-feira apelando às principais empresas de IA, incluindo a OpenAI, para estabelecerem maior transparência e mais proteções para os denunciantes. “Enquanto não houver uma supervisão governamental eficaz destas empresas, os actuais e antigos funcionários estarão entre as poucas pessoas que os podem responsabilizar perante o público”, diz a carta.

Chame-me de pessimista, mas espero que os apelos dos ex-funcionários caiam em ouvidos surdos. É difícil imaginar um cenário em que as empresas de IA não só concordem em “apoiar uma cultura de crítica aberta”, como recomenda o abaixo-assinado, mas também optem por não impor cláusulas de não depreciação ou retaliar contra os actuais funcionários que optem por se manifestar.

Considere que a comissão de segurança da OpenAI, que a empresa criou recentemente em resposta a inicial críticas às suas práticas de segurança, conta com todos os membros da empresa – incluindo o CEO Sam Altman. E considere que Altman, que a certa altura alegou não ter conhecimento dos acordos restritivos de não depreciação da OpenAI, ele mesmo assinado os documentos constitutivos que os estabelecem.

Claro, as coisas na OpenAI podem mudar amanhã – mas não estou prendendo a respiração. E mesmo que o fizessem, seria difícil confiar nisso.

Notícias

Apocalipse da IA: A plataforma de chatbot baseada em IA da OpenAI, ChatGPT – junto com Claude da Anthropic e Gemini e Perplexity do Google – todos foi abaixo esta manhã, aproximadamente à mesma hora. Todos os serviços foram restaurados desde então, mas a causa do tempo de inatividade permanece obscura.

OpenAI explorando fusão: A OpenAI está em negociações com a startup de fusão Helion Energy sobre um acordo no qual a empresa de IA compraria grandes quantidades de eletricidade da Helion para fornecer energia para seus data centers, de acordo com o Wall Street Journal. Altman tem uma participação de US$ 375 milhões na Helion e faz parte do conselho de administração da empresa, mas ele teria se recusado a participar das negociações do acordo.

O custo dos dados de treinamento: O TechCrunch analisa os caros acordos de licenciamento de dados que estão se tornando comuns na indústria de IA – acordos que ameaçam tornar a pesquisa em IA insustentável para organizações menores e instituições acadêmicas.

Geradores de música odiosos: Atores maliciosos estão abusando de geradores de música alimentados por IA para criar músicas homofóbicas, racistas e propagandísticas – e publicando guias que instruem outras pessoas sobre como fazê-lo também.

Dinheiro para Cohere: A Reuters relata que a Cohere, uma startup de IA generativa com foco empresarial, levantou US$ 450 milhões da Nvidia, Salesforce Ventures, Cisco e outras em uma nova parcela que avalia a Cohere em US$ 5 bilhões. Fontes conhecidas disseram ao TechCrunch que Oracle e Thomvest Ventures – ambos investidores recorrentes – também participaram da rodada, que foi deixada em aberto.

Artigo de pesquisa da semana

Em um artigo de pesquisa de 2023 intitulado “Vamos verificar passo a passo” se OpenAI recentemente destacado em seu blog oficial, cientistas da OpenAI afirmaram ter ajustado o modelo de IA generativa de uso geral da startup, GPT-4, para alcançar um desempenho melhor do que o esperado na resolução de problemas matemáticos. A abordagem poderia levar a modelos generativos menos propensos a sair dos trilhos, dizem os coautores do artigo – mas eles apontam várias advertências.

No artigo, os coautores detalham como treinaram modelos de recompensa para detectar alucinações ou casos em que o GPT-4 errou em seus fatos e/ou respostas a problemas matemáticos. (Os modelos de recompensa são modelos especializados para avaliar os resultados dos modelos de IA, neste caso os resultados relacionados à matemática do GPT-4.) Os modelos de recompensa “recompensaram” o GPT-4 cada vez que ele acertava uma etapa de um problema matemático, uma abordagem os pesquisadores chamam de “supervisão de processo”.

Os pesquisadores dizem que a supervisão do processo melhorou a precisão dos problemas matemáticos do GPT-4 em comparação com técnicas anteriores de modelos “recompensadores” – pelo menos em seus testes de benchmark. Eles admitem que não é perfeito; O GPT-4 ainda errou nas etapas do problema. E não está claro como a forma de supervisão de processos explorada pelos pesquisadores pode ser generalizada para além do domínio matemático.

Modelo da semana

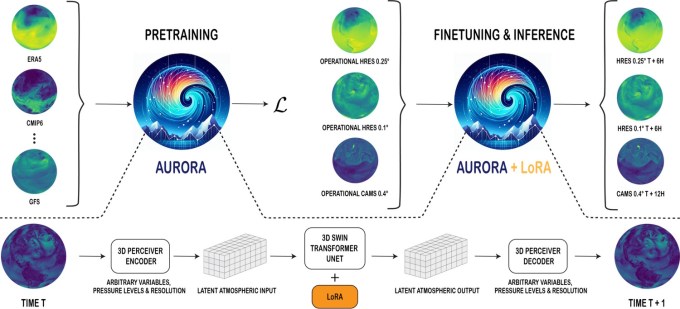

Prever o tempo pode não parecer uma ciência (pelo menos quando chove, como acabei de fazer), mas isso é porque se trata de probabilidades, não de certezas. E que melhor maneira de calcular probabilidades do que um modelo probabilístico? Já vimos a IA colocada em prática na previsão do tempo em escalas de tempo de horas a séculos, e agora a Microsoft está entrando na diversão. A empresa novo modelo Aurora move a bola para frente neste canto em rápida evolução do mundo da IA, fornecendo previsões em nível global com resolução de aproximadamente 0,1° (pense na ordem de 10 km quadrados).

Treinado em mais de um milhão de horas de simulações meteorológicas e climáticas (não o tempo real? Hmm…) e ajustado em uma série de tarefas desejáveis, aurora supera os sistemas tradicionais de previsão numérica em várias ordens de magnitude. O mais impressionante é que ele supera o GraphCast do Google DeepMind em seu próprio jogo (embora a Microsoft tenha escolhido o campo), fornecendo estimativas mais precisas das condições climáticas na escala de um a cinco dias.

Empresas como Google e Microsoft têm um cavalo na corrida, é claro, ambas disputando sua atenção online ao tentar oferecer a experiência de pesquisa e web mais personalizada. Previsões meteorológicas precisas e eficientes serão uma parte importante disso, pelo menos até pararmos de sair de casa.

Sacola

Em um pensamento peça no mês passado em Palladium, Avital Balwit, chefe de equipe da startup de IA Anthropic, postula que os próximos três anos podem ser os últimos que ela e muitos trabalhadores do conhecimento terão de trabalhar, graças aos rápidos avanços da IA generativa. Isso deveria ser um conforto e não um motivo para medo, diz ela, porque poderia “[lead to] um mundo onde as pessoas tenham as suas necessidades materiais satisfeitas, mas também não tenham necessidade de trabalhar.”

“Um renomado pesquisador de IA me disse uma vez que está praticando para [this inflection point] realizando atividades nas quais ele não é particularmente bom: jiu-jitsu, surf e assim por diante, e saboreando o que faz mesmo sem excelência”, escreve Balwit. “É assim que podemos nos preparar para o nosso futuro, onde teremos que fazer as coisas por alegria e não por necessidade, onde não seremos mais os melhores nisso, mas ainda teremos que escolher como preencher nossos dias.”

Essa é certamente a visão do copo meio cheio – mas não posso dizer que compartilho.

Se a IA generativa substituir a maioria dos trabalhadores do conhecimento dentro de três anos (o que me parece irrealista, dados os muitos problemas técnicos não resolvidos da IA), o colapso económico poderá muito bem ocorrer. Os trabalhadores do conhecimento compõem grandes porções da força de trabalho e tendem a ter altos rendimentos – e, portanto, grandes gastadores. Eles impulsionam as rodas do capitalismo.

Balwit faz referências ao rendimento básico universal e a outros programas de redes de segurança social em grande escala. Mas não tenho muita fé que países como os EUA, que não conseguem sequer gerir a legislação básica sobre IA a nível federal, adoptem esquemas de rendimento básico universal tão cedo.

Com alguma sorte, estou errado.