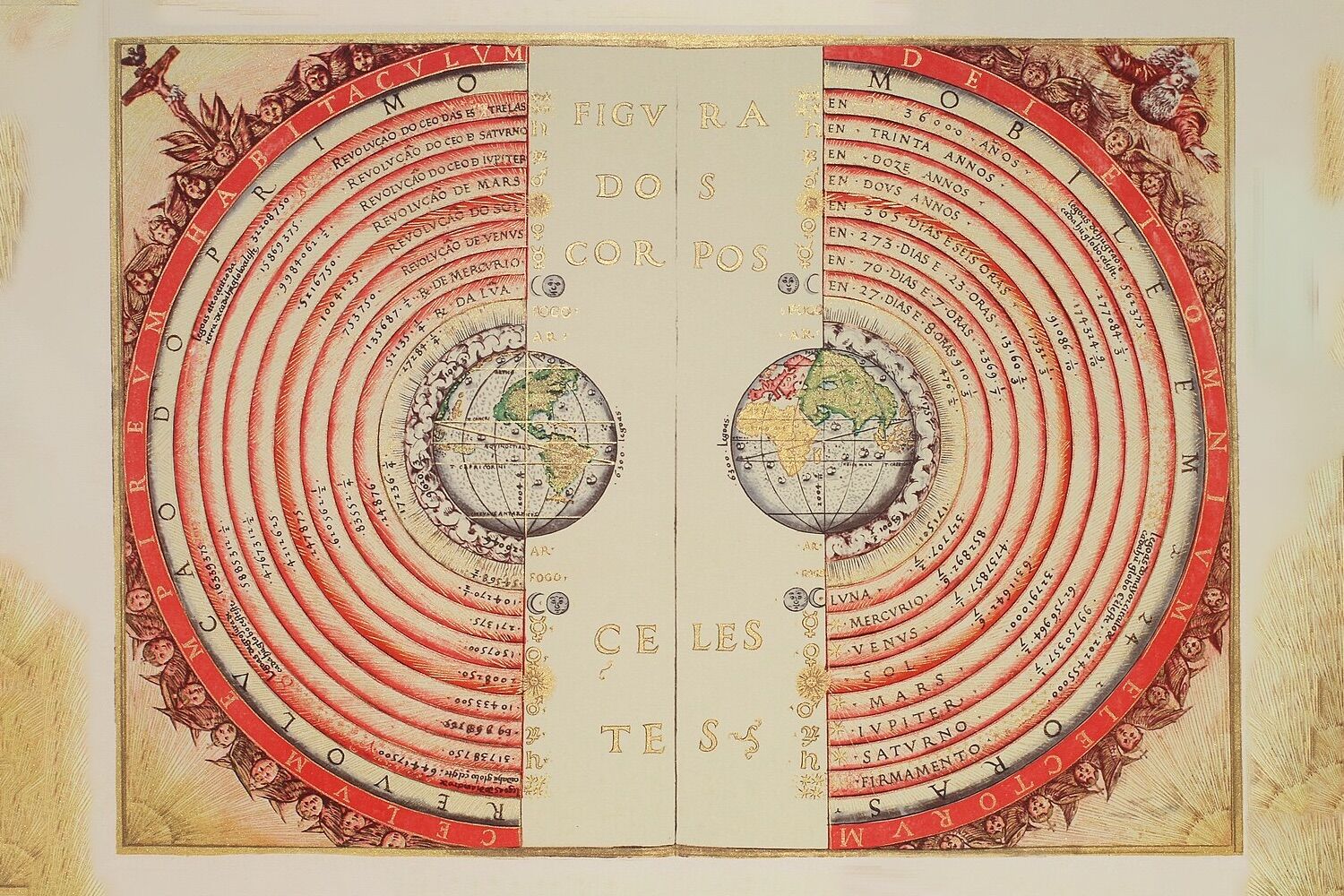

Os Corpos Celestes, lustração do conceito geocêntrico ptolemaico do Universo, pelo cosmógrafo e cartógrafo português Bartolomeu Velho (1568)

Um exercício interessante, que eliminou o progresso científico de 200 anos, demonstrou que a IA não é capaz de gerar conhecimento por si mesma — mas é surpreendentemente capaz de contextualizar informação factualmente correta.

Treinar uma inteligência artificial para que raciocine como se os séculos XX e XXI não tivessem existido deixou de ser um exercício imaginativo.

Uma experiência recente mostra que, ao limitar de forma extrema os dados de treino, uma IA responde como se ainda vivêssemos no século XIXcom resultados tão coerentes quanto perturbadores do ponto de vista tecnológico e científico.

O projeto parte de uma premissa básica dos modelos de linguagem: estes sistemas não geram conhecimento novomas elaboram as suas respostas a partir dos textos com os quais foram treinados.

Como consequência, os modelos de aprendizagem automática não conseguem gerar textos sobre descobertas científicas que ainda não aconteceramporque não existe literatura sobre essas descobertas. O melhor que uma IA pode fazer é repetir previsões escritas por investigadores ou sintetizar essas previsões, explica a Ciência Popular.

A partir desta perspetiva, surge uma questão fundamental para a investigação em inteligência artificial: se um modelo só tem acesso a documentos de uma época concreta, acabará por pensar como as pessoas desse período histórico?

Esta ideia esteve na origem do TimeCapsuleLLMum projeto experimental sem intuitos comerciais, que atua como se o progresso científico e social posterior nunca tivesse ocorrido, e que pode ser encontrado no GitHub.

O modelo, desenvolvido por Hayk Grigorianestudante do Muhlenberg College, nos EUA, foi treinado com 90 mil milhões de bytes de textos publicados em Londres entre 1800 e 1875um período marcado por profundas transformações políticas e sociais.

Embora o modelo nem sempre mantenha uma narrativa sólida, as suas respostas surpreenderam pela contextualização histórica. Segundo contou Grigorian no Reddito resultado mais intrigante do TimeCapsuleLLM surgiu de um teste simples.

Quando instruído a completar a frase “Era o ano de Nosso Senhor de 1834”, o modelo de IA gerou o seguinte texto: “Corria o ano de Nosso Senhor de 1834 e as ruas de Londres estavam repletas de protestos e petições. A causa, como muitos relataram, não se restringia ao âmbito privado, mas, tendo surgido no mesmo dia em que Lord Palmerston a governava, o público receberia um breve relato das dificuldades que levaram o dia da lei a chegar até nós“.

Curioso sobre a exatidão das informações, Grigorian foi verificar os factos. “O resultado mencionava Lord Palmerston, e depois de uma pesquisa no Google, descobri que as suas ações resultaram efetivamente nos protestos de 1834.”

Potencialmente, um LLM treinado com exclusivamente com informação de um dado período histórico, ou “Historical Large Language Model” (HLLM), seria capaz de representar os padrões de conduta, por exemplo, dos vikings ou dos primeiros romanos.

Este tipo de modelos tem porém alguns risco e limitações. Num artigo de opinião no História Experimental, Adam Mastroianni dá um exemplo: “Se treinássemos uma IA com Grécia antiga, a alimentássemos com todo o conhecimento humano e lhe perguntássemos como aterrar na Luaresponderia que isso é impossível, já que a Lua é um deus que flutua no céu“.

Assim, se treinássemos um HLLM com dados do século XVI, a IA juraria a pés juntos que a Terra era o centro do Universoque os objetos pesados caíam mais depressa que os mais leves… e que seres vivos podiam surgir espontaneamente de matéria inanimada, como moscas a partir do lixo, e ratos do trigo.

Núm. artigo científico publicado em 2024 na Anais da Academia Nacional de Ciênciasos autores sugerem os HLLM poderiam servir para estudar a psicologia humana fora do contexto modernopermitindo analisar padrões culturais e sociais de civilizações passadas mediante simulações computacionais.

“Em princípio, as respostas dos HLLM poderiam refletir a psicologia das sociedades passadas, permitindo uma ciência da natureza humana mais robusta e interdisciplinar”, dizem os autores do artigo.

“Os investigadores poderiam, por exemplo, comparar as tendências cooperativas dos vikings, dos antigos romanos e dos japoneses do início da era moderna em jogos económicos. Ou poderiam explorar atitudes sobre os papéis de género que eram típicas entre os antigos persas ou os europeus medievais”, acrescentam.

Contudo, os próprios investigadores alertam para limitações destes modelos. Os textos históricos conservados refletem, na sua maioria, a visão de elites sociaiso que introduz um enviesamento estrutural difícil de corrigir.

A isto soma-se a influência ideológica dos programadoresque um estudo conduzido por investigadores da Universidade de Ghent, na Bélgica, e publicado este mês na npj Artificial Intelligencedeterminou ser um fator determinante nos resultados gerados pelos modelos de linguagem.

Assim, os modelos de IA treinados com dados de séculos passados apresentam, na prática, exatamente os mesmos problemas que os LLM do nosso tempo.